KT Aivle School 에이블스쿨 기자단] 9.11(월) ~ 9.17(일) 해커톤 회의, 코딩 마스터즈 마감, 그 와중에 예비군 작성

이번 주의 스케줄

- 월~금 KT 에이블스쿨 머신러닝 수업

- 금요일 코딩마스터즈 마감

- 토요일 예비군(인천 서구동구 예비군 훈련장)

- 일요일 5시 해커톤 회의

- 일요일 8시 프로그래머스 스터디(내가 주관!)

- 일요일 책 하나 읽을 예정이었으나 예비군, 해커톤, 프로그래머스 스터디 3연타로 포기....

- 이장래 강사님 마지막 수업

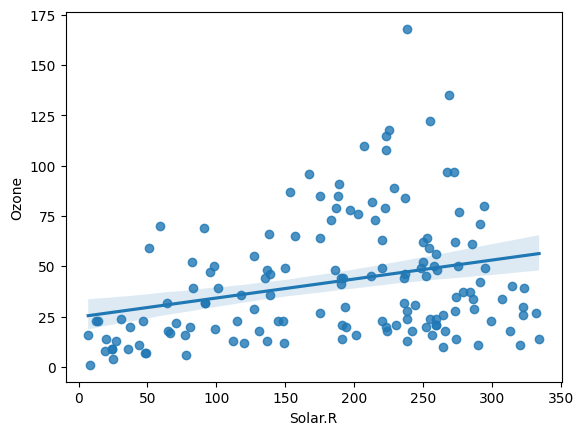

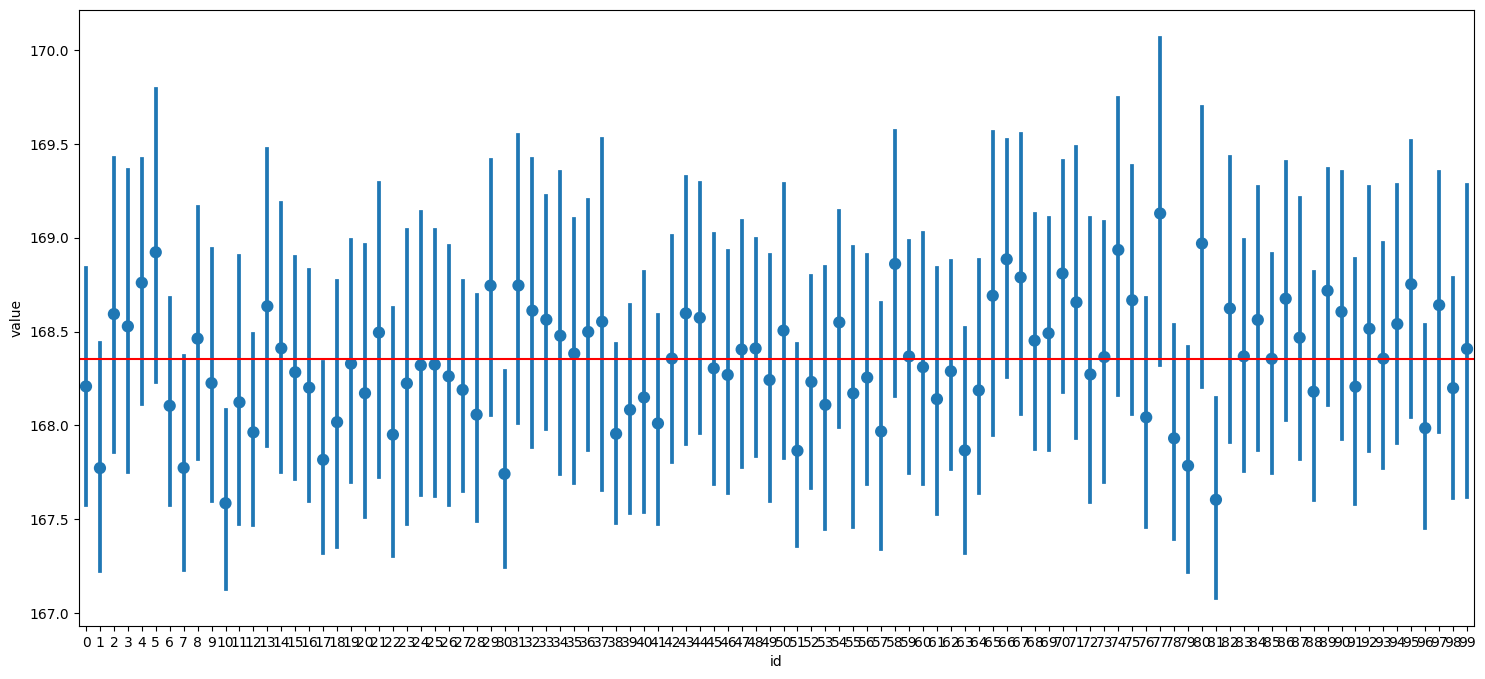

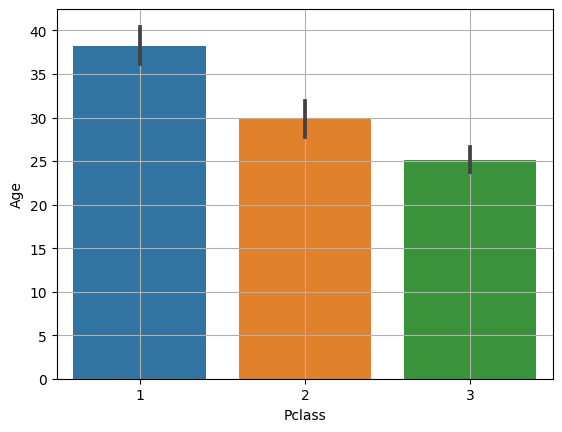

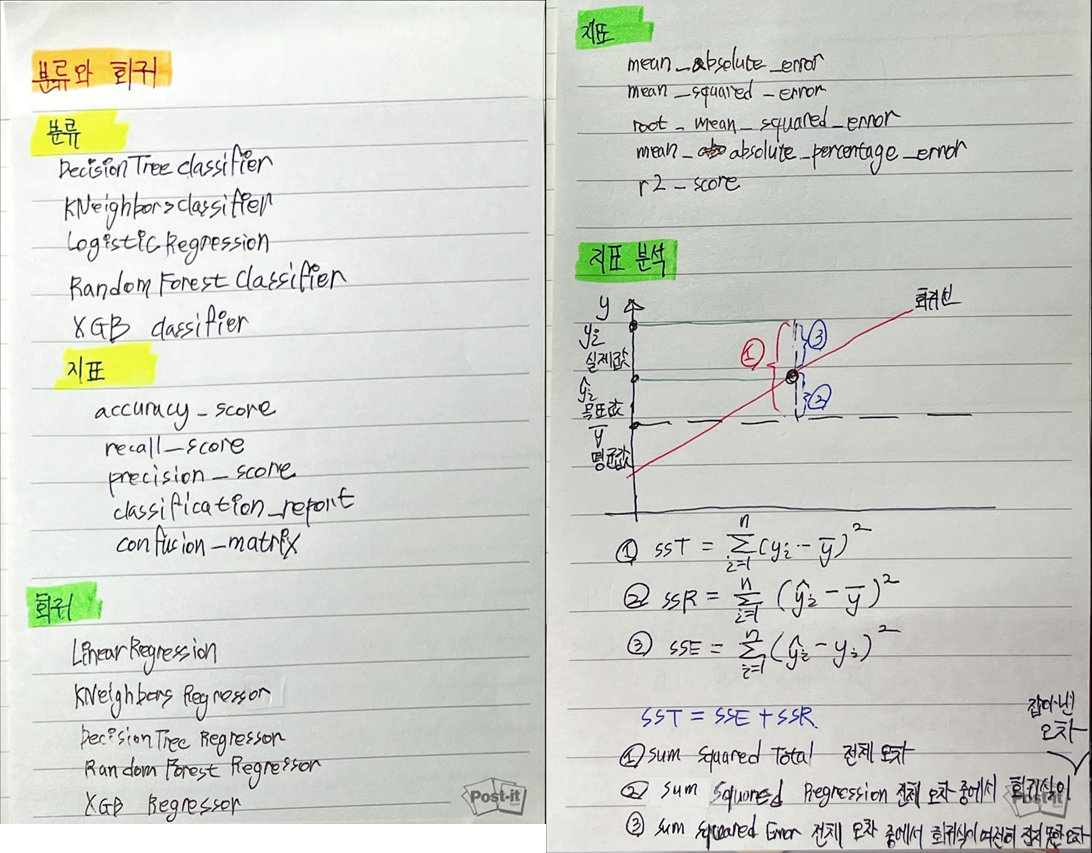

- 회귀와 분류

- 공모전 빅콘 --> DBI 2023

- 코멘토

코딩 마스터즈 최종 성적

아직 난 하찮은 실력임을 다시 확인할 수 있었다

이번 주는 공모전 준비와 토요일 예비군으로 바빴지만 에이블러라면 이거를 핑계로 삼지는 말자!

이장래 강사님과의 마지막 수업ㅠ

파이썬 기초 문법으로 뵈었던게 얼마 안된 거 같은데

머신러닝 지도학습 수업을 마지막으로 이제 에이블스쿨 교육에서는 뵐 일이 없어졌다ㅠ

나는 인프런 강의에서 또 뵙겠지만 아쉬운건 어쩔 수 없는 거 같다

해커톤 일요일 회의

이번 해커톤 회의에서 개인적으로 기뻤던 부분은 내 아이디어가 매우 긍정적인 평가를 받았던 것이다

난이도 문제로 살짝의 수정이 필요하지만 develop하는 과정 또한 흥미로울 거라 생각한다

DX 참여자로서 기획, 데이터 부분에서 밥값을 해야한다고 느끼고 있는데 일단 첫 단추는 잘 끼운 듯

아이디어에 대한 자세한 설명은 해커톤이 어느 정도 진행되면 첨부할게요~

공모전 변경

처음 함께 서울 공공 데이터 활용 공모전에 나갔던 에이블러들과 새로운 공모전을 탐색 중이다.

나는 다시 조장 역할을 수행 예정이다

처음에는 이 공모전을 선정했으나 시간 관리 문제로 서류 작성 시간이 모자라져서 아래 공모전으로 변경했다

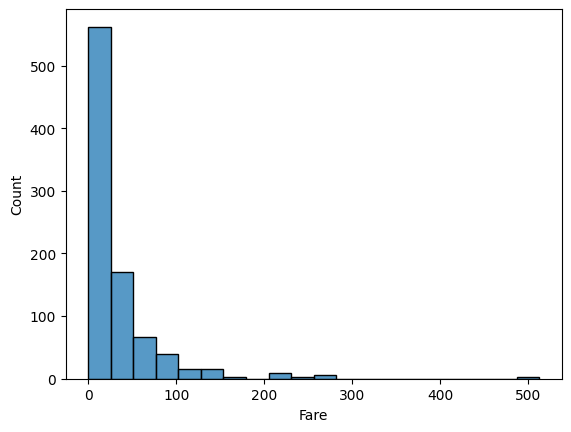

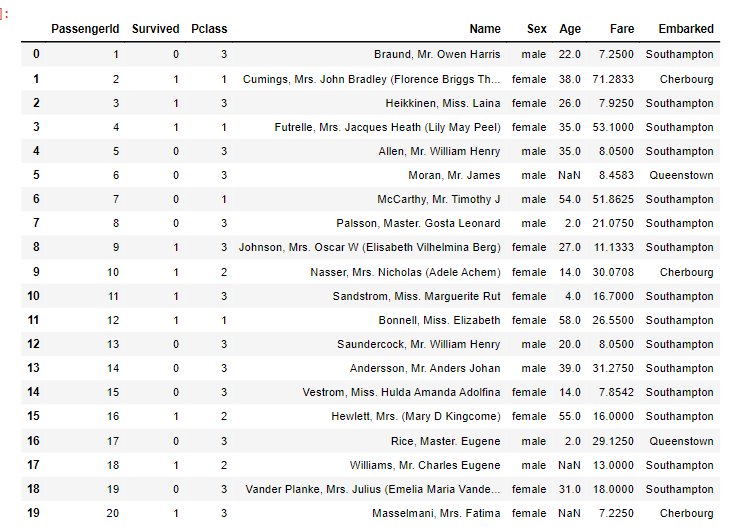

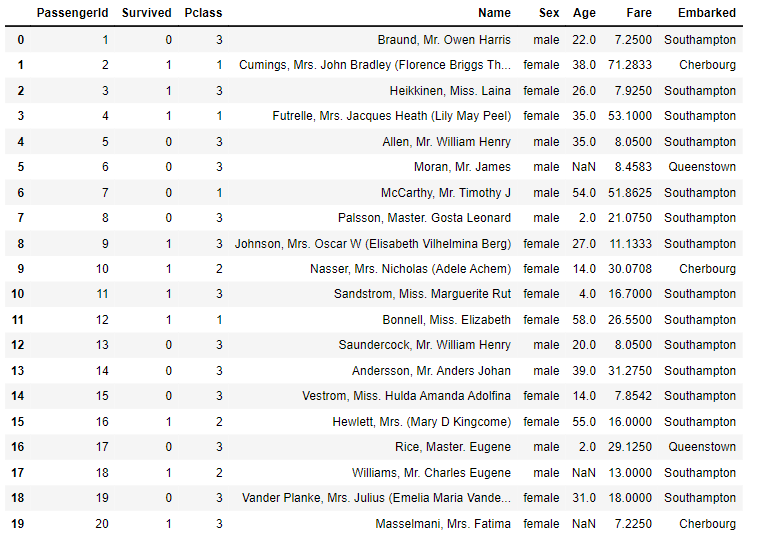

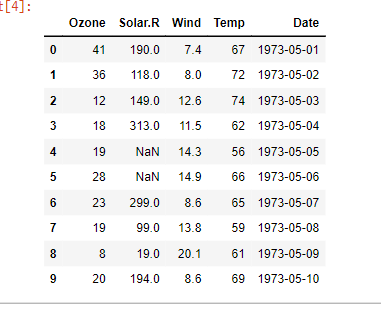

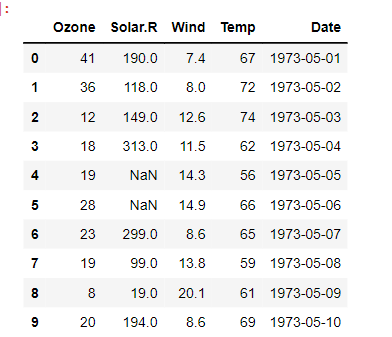

도메인 지식을 늘리는 데 도움이 될 거 같긴 하지만 아래의 데이터들이 내가 분석해야 할 데이터 목록들... 나 할 수 있겠지...??

10,000개의 기업들을 분석해야 한다. 결측치들은 또 어떻게 처리해야 될라나

내용정리

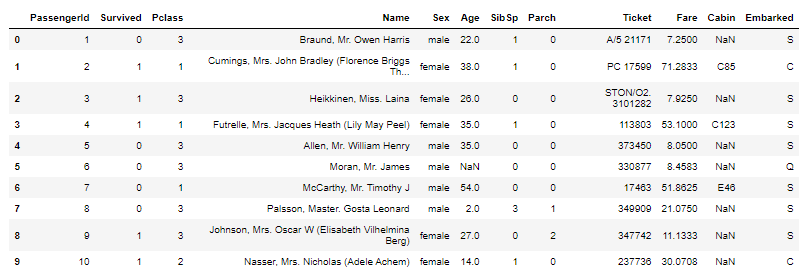

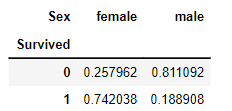

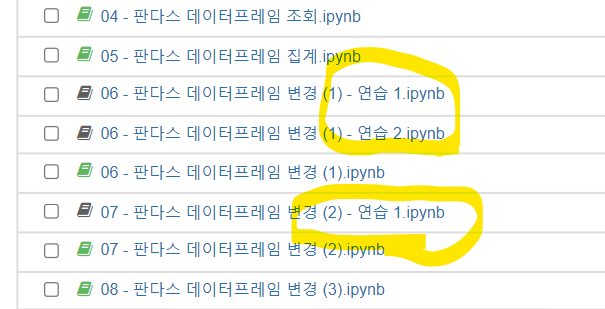

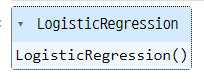

# 선언하기

model = LogisticRegression()

# 학습하기

model.fit(x_train, y_train)

# 평가하기

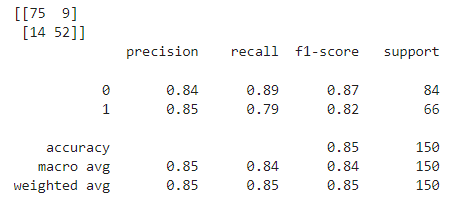

print(confusion_maxtrix(y_test, y_pred))

print(classification_report(y_test, y_pred))

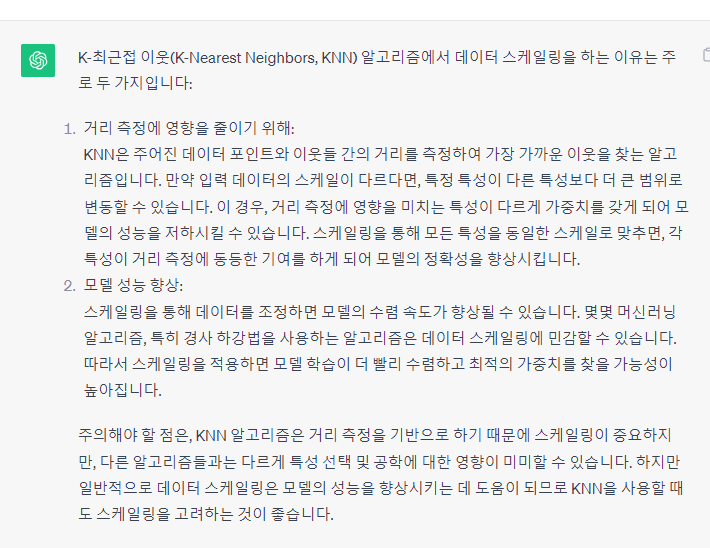

# KNN에서 스케일링을 수행하는 이유 검색

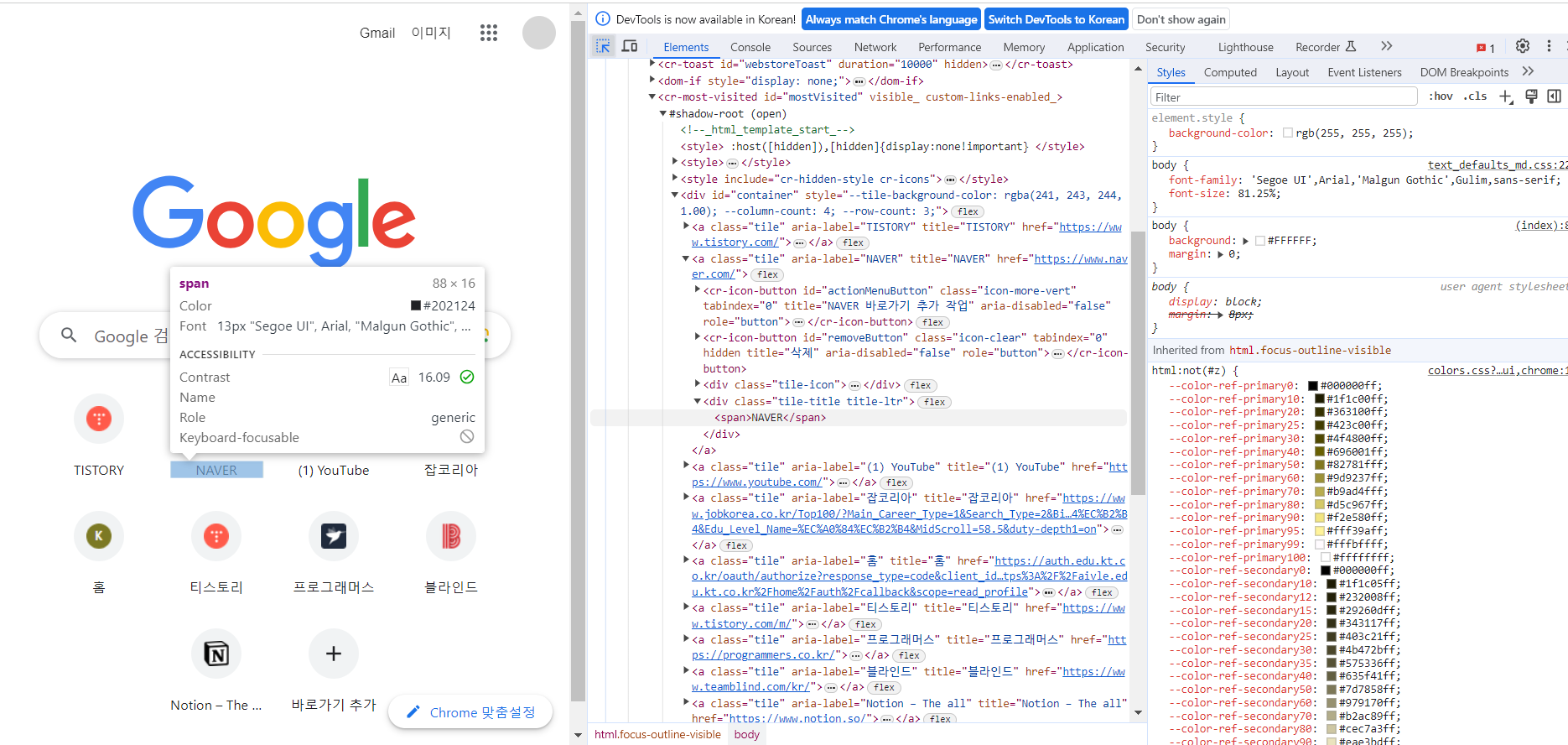

# 수업 필기

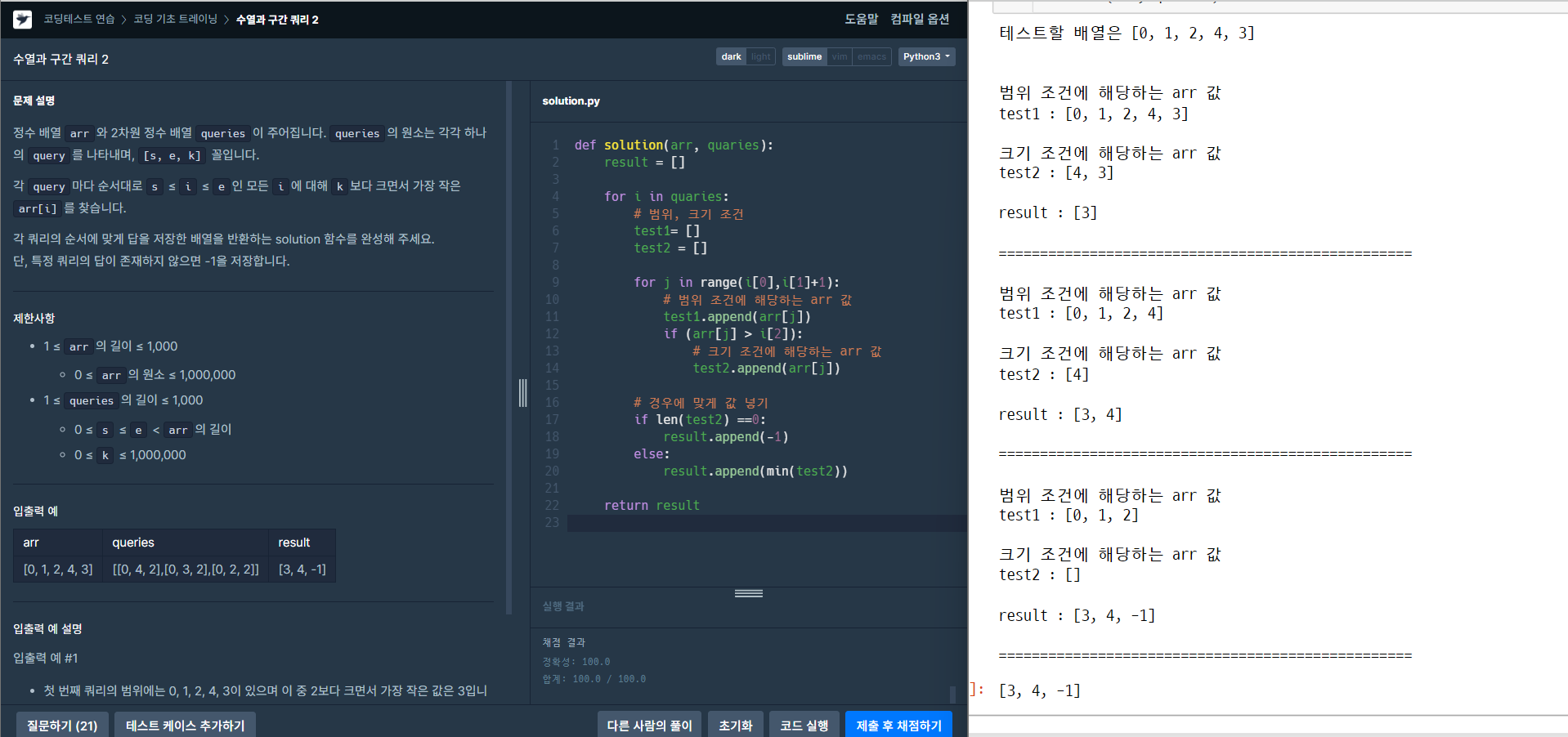

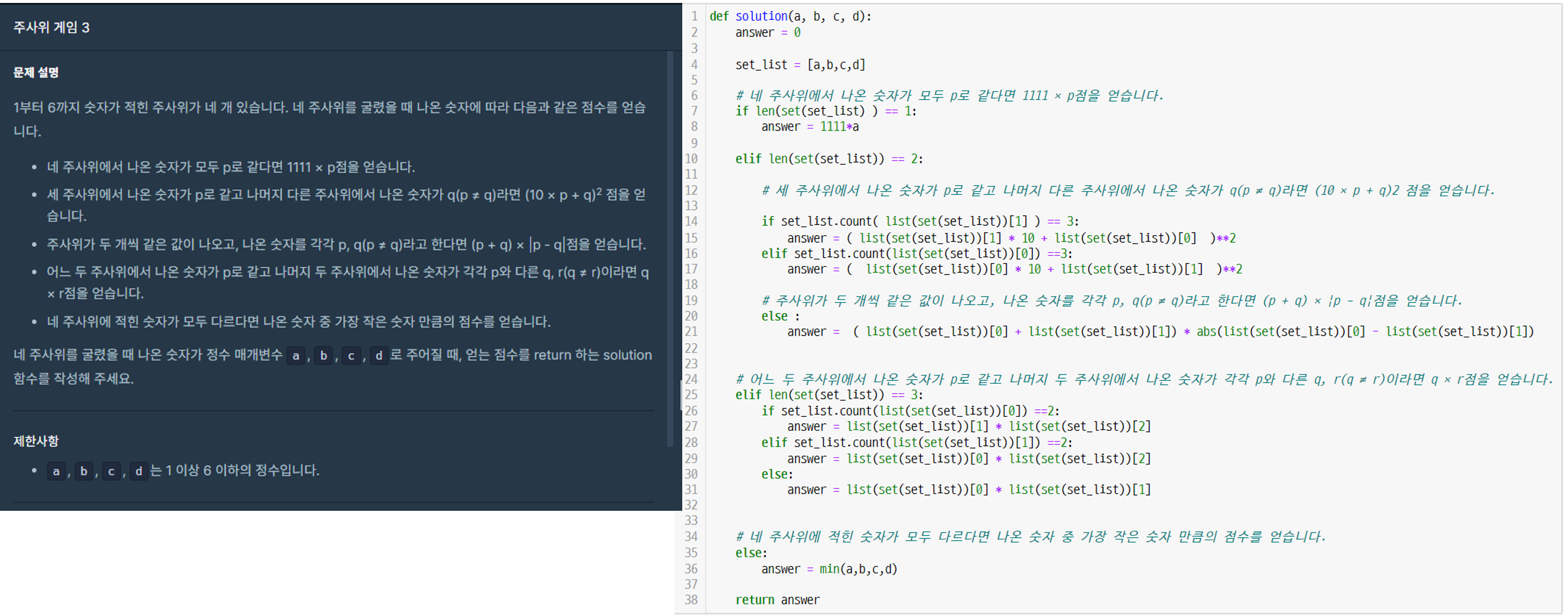

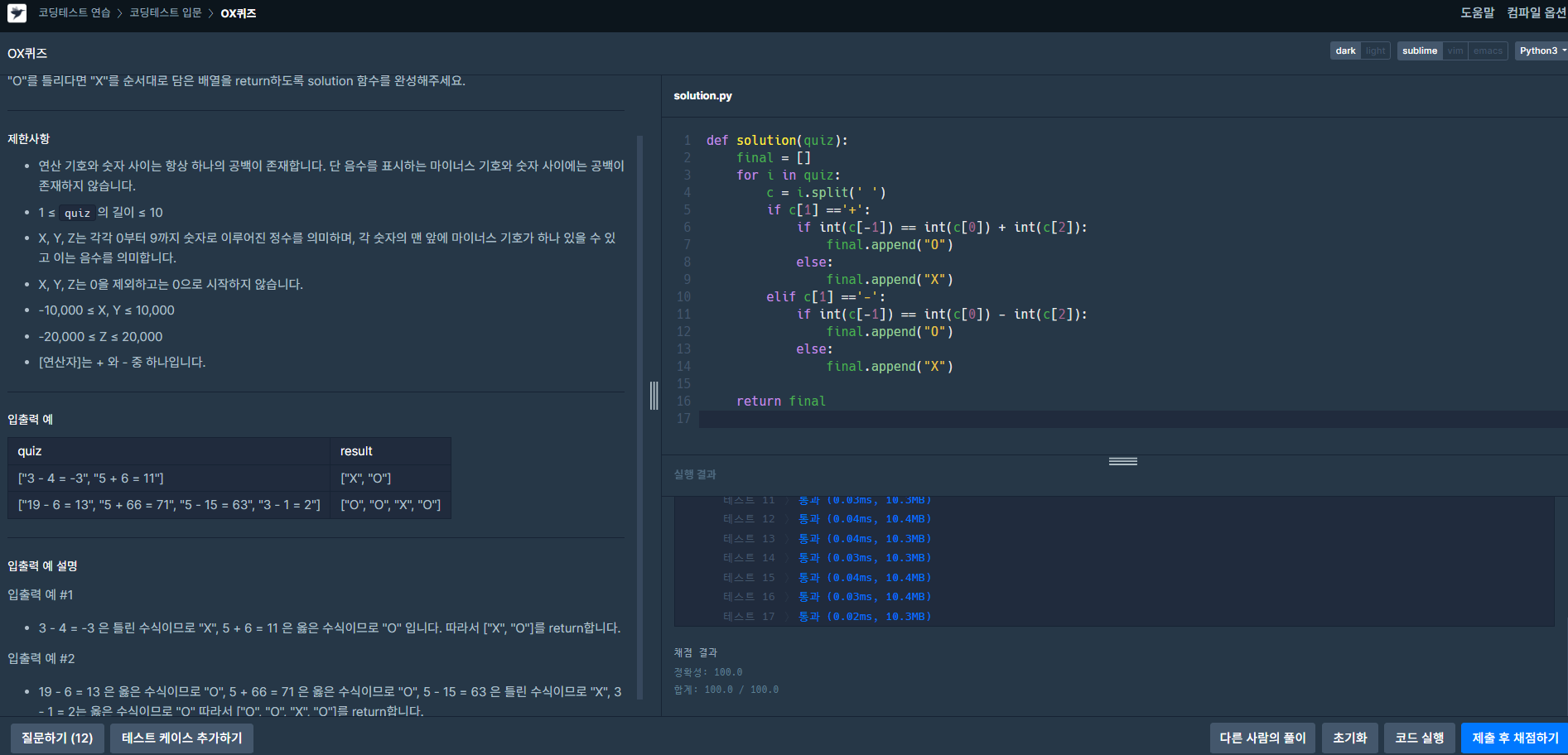

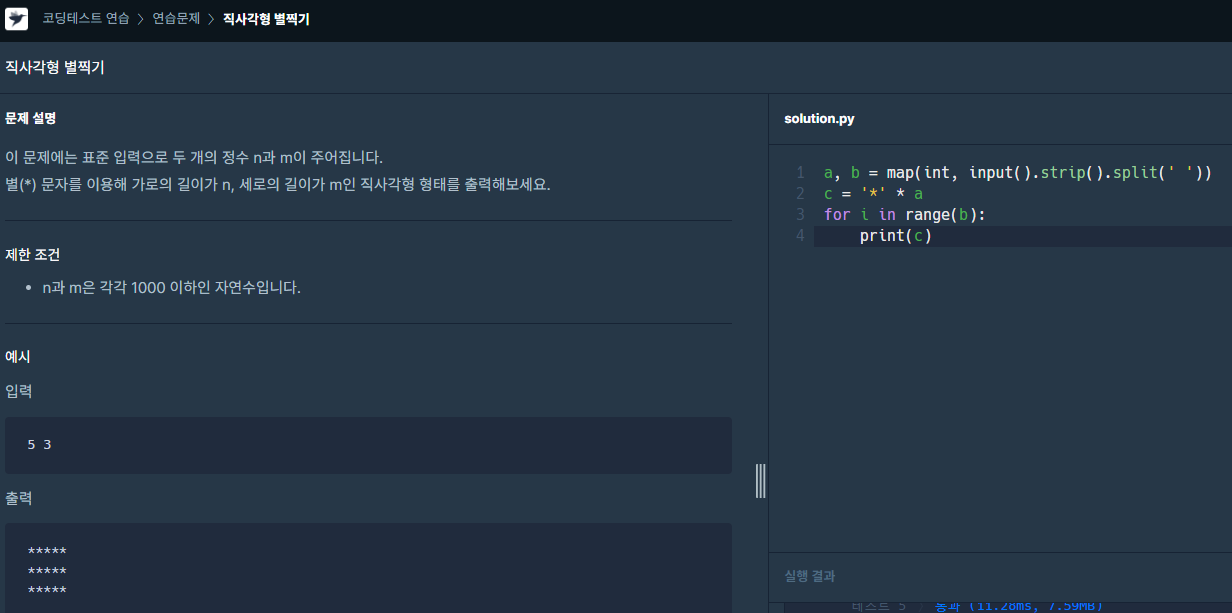

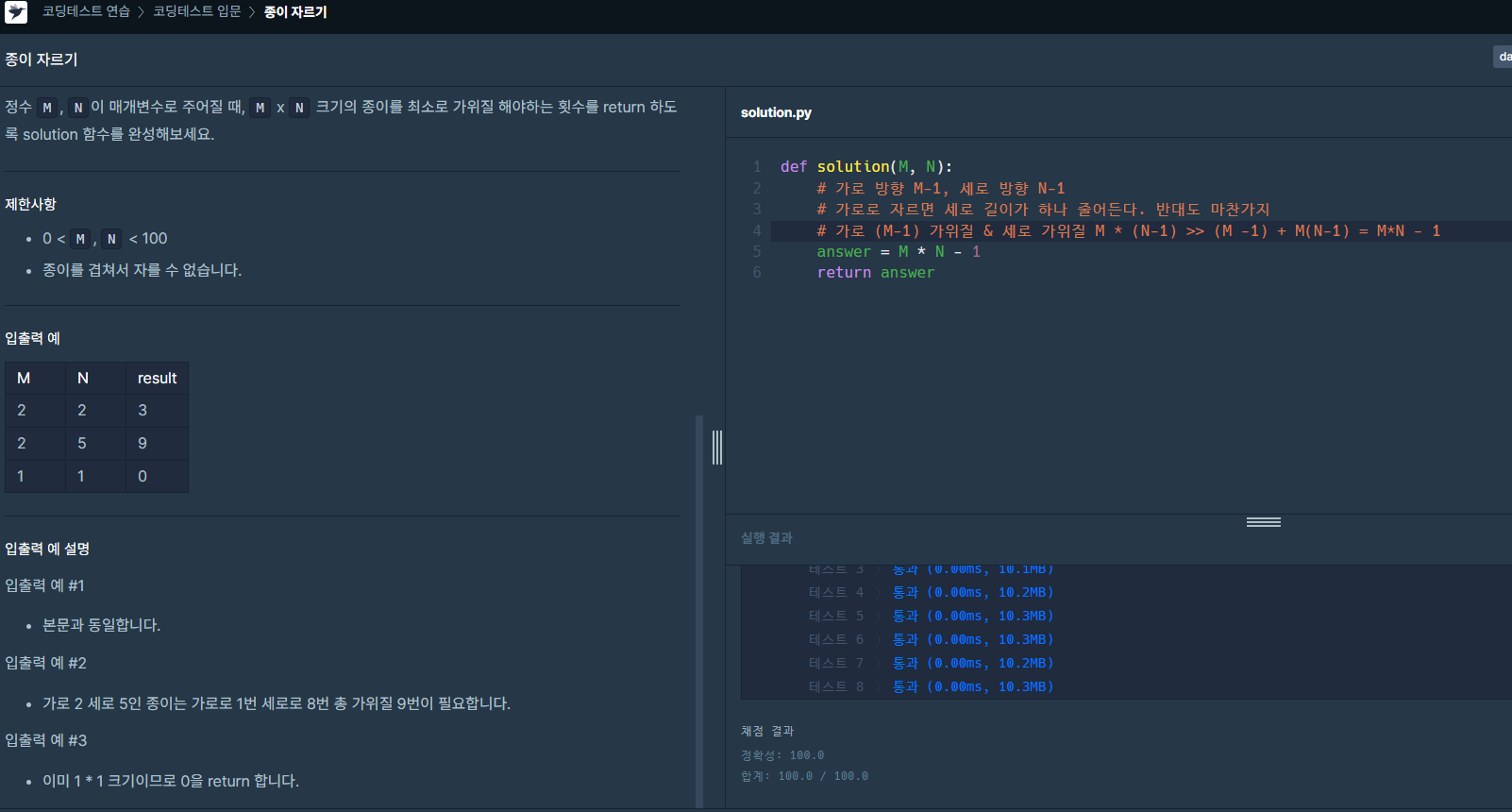

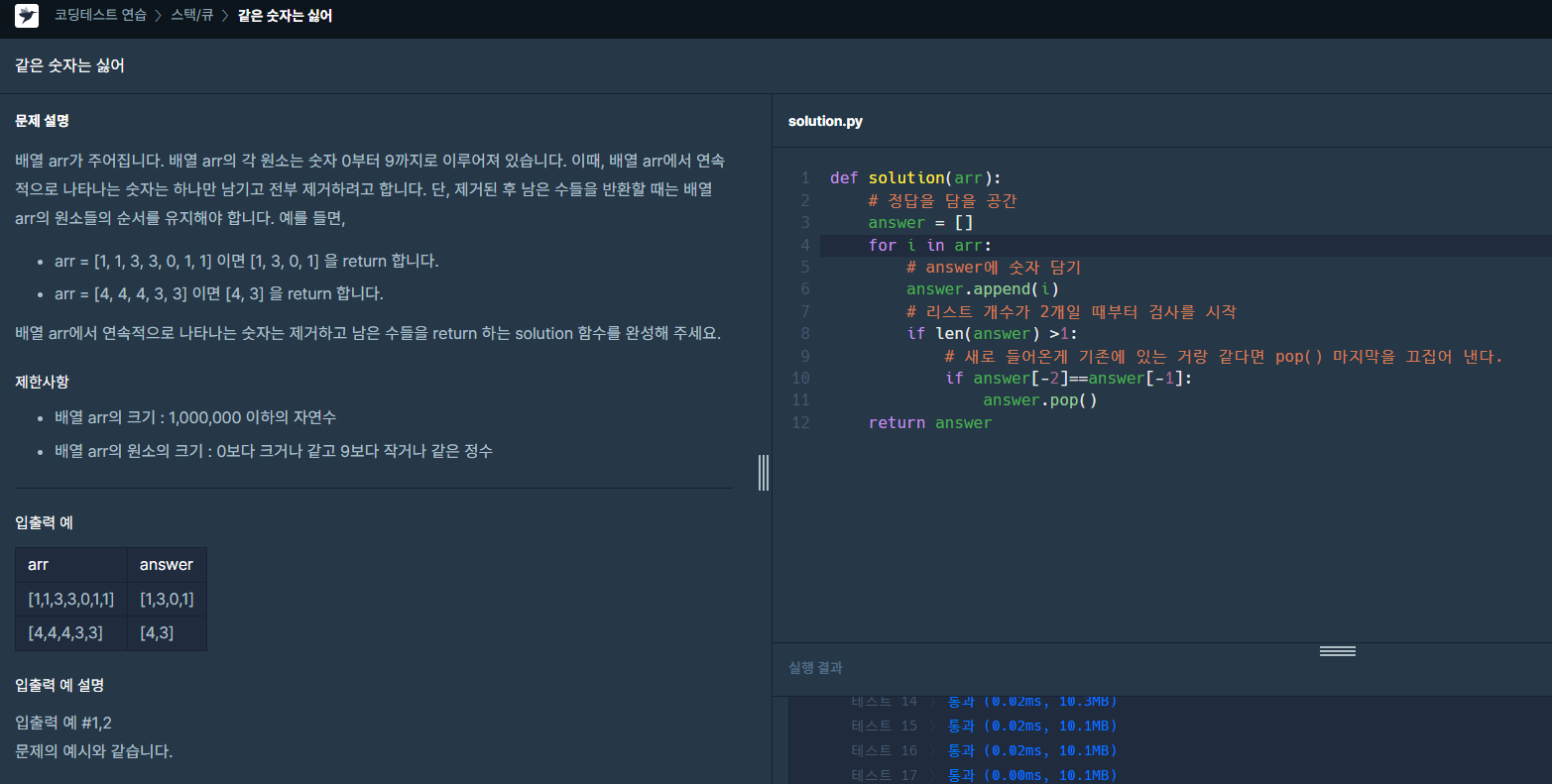

이번주 프로그래머스

이번 프로그래머스 스터디를 진행하며 당황스러웠던 점은 하는 중간에 프로그래머스 팀즈 채널이 삭제된 것이었다!

팀원들에게 자유롭게 팀즈 공간을 꾸밀 수 있도록 모두 소유자 권한을 주었는데 아마 한 분이 실수한거 아닐까 싶다

이번 사태 이후로는 소유자 권한은 현재 리더를 맡고 있은 나만 가질 계획

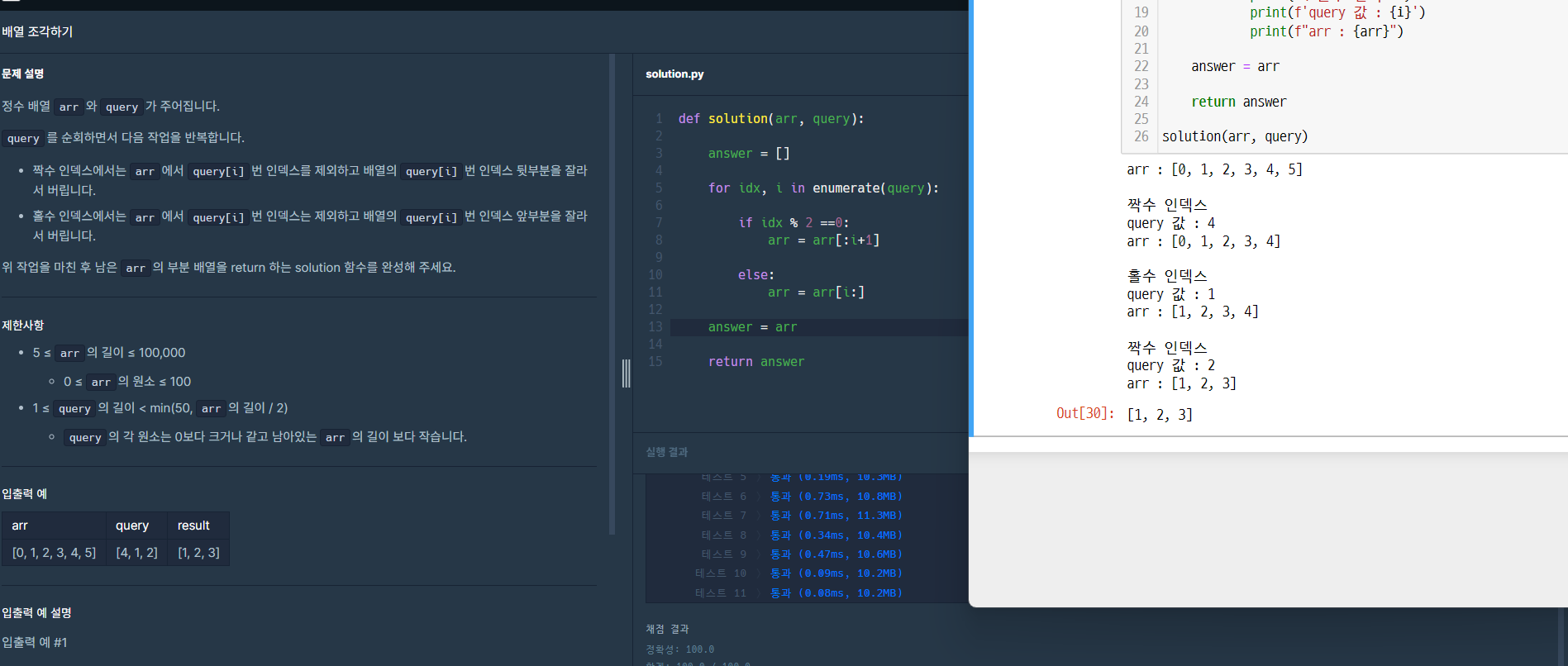

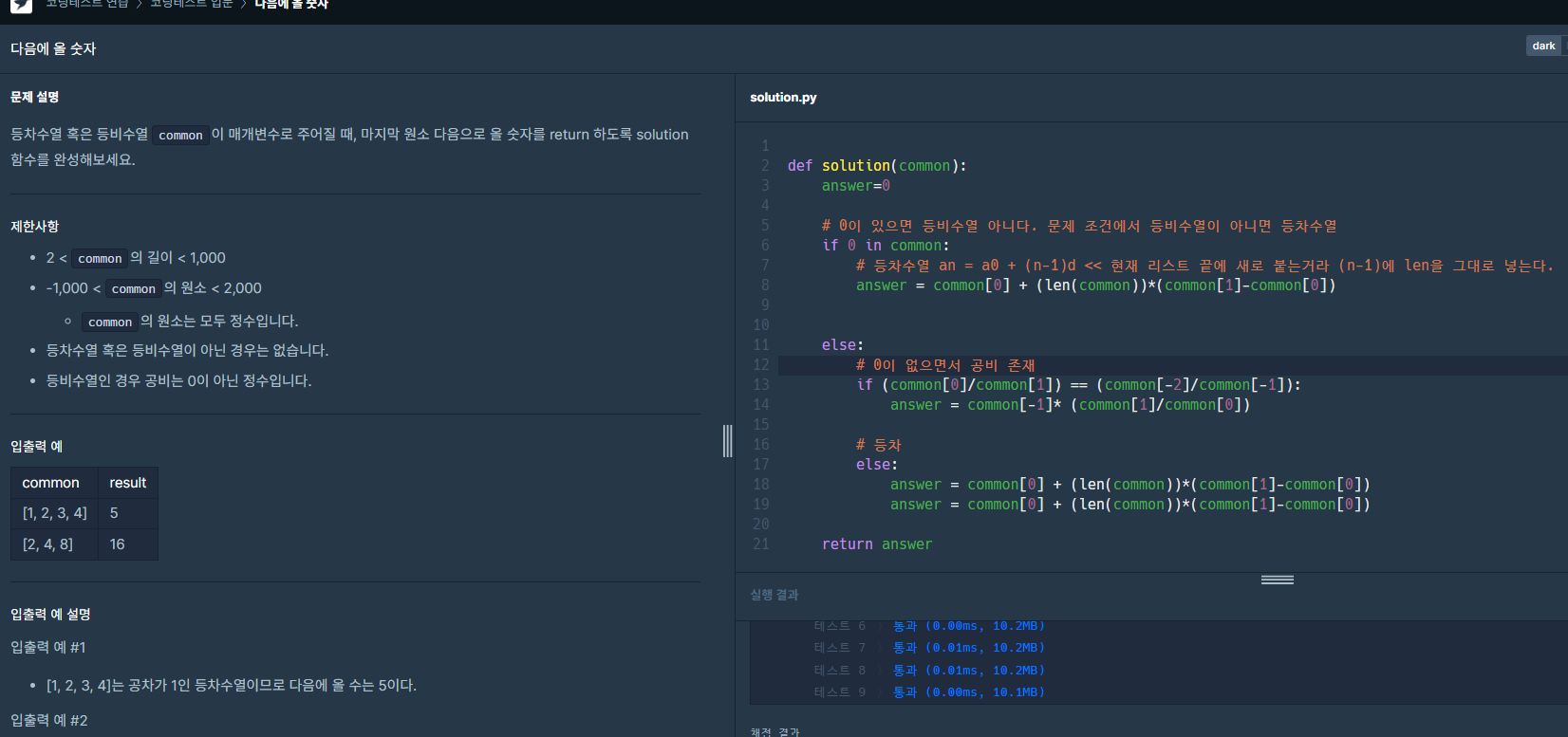

문제풀이

프로그래머스 문제 풀이 중 알쏭달쏭했던 점 겹치는 선분의 길이

바쁜 스케줄로 읽지도 못하고 반납한 책...ㅠ

|

|