KT Aivle School 에이블스쿨 기자단] 10.02(월) ~ 10.8(일) 코랩 결제, AICE, 듀얼 모니터

내용

- 구글 코랩 결제

- AICE ASSOCIATE 무료 응시 기회!!

- 집에 있던 모니터와 듀얼 모니터 연결

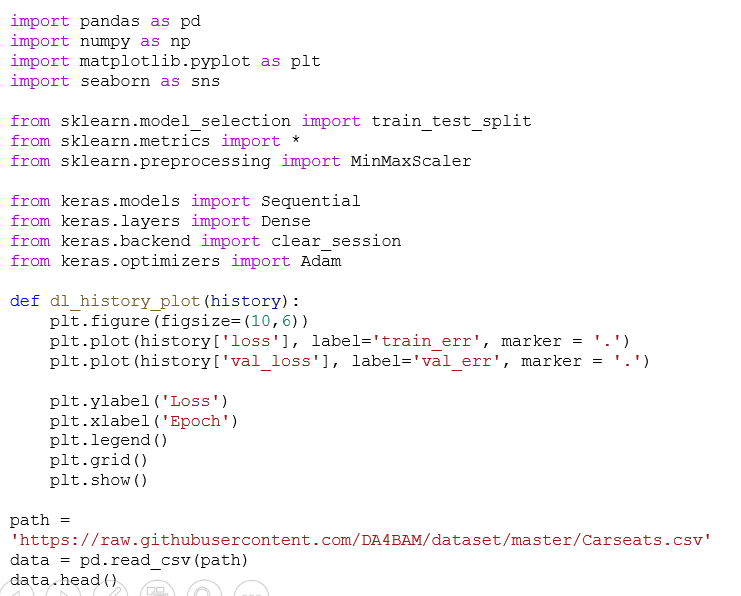

구글 코랩 결제

원활한 미프 진행을 위해 KT에서 구글 Colaboratoy Pro 버전 비용을 지원해주었다

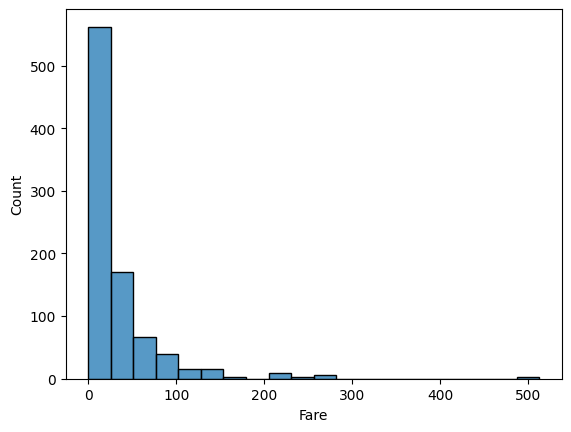

인공지능 학습을 위해서는 GPU의 성능이 중요했기 때문이고, 앞으로는 T4 GPU 기능을 원활하게 사용할 예정

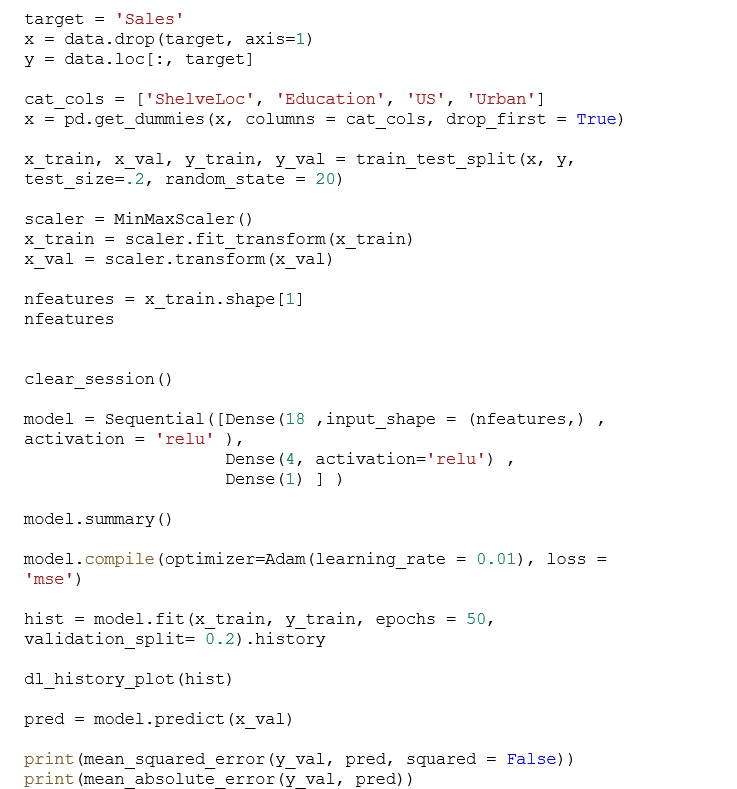

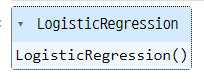

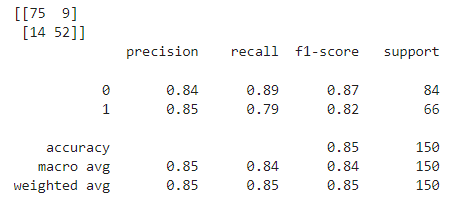

AICE 자격증

KT AIVLE School에서는 특별히 에이블러들을 위해 AICE 자격증 ASSOCIATE 등급 시험 비용을 지원해주고 있다.

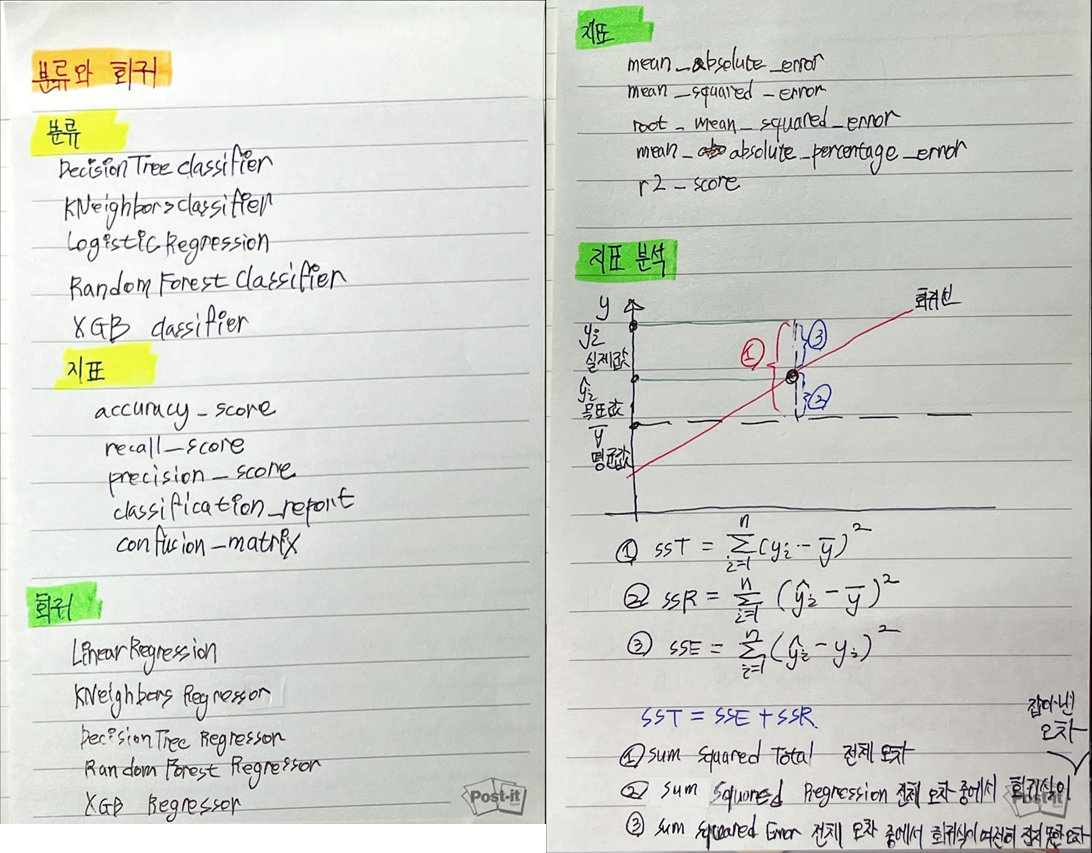

AI 역량 개발을 위하여 KT가 만든 자격증으로 이 자격증을 공부하고 취득한다면 AI 역량을 키워감에 있어 큰 도움이 될 거라 생각한다.

수업 때 공부한 인공지능 이론을 다시 복습하며 자격증에 도전하려고 한다.

집에 있던 모니터와 듀얼 모니터 연결

그동안은 Twomon SE 어플을 통해 아이패드를 듀얼 모니터로 사용하고 있었으나 코드가 점점 길어지고 내용이 복잡해지며 한계를 느꼈다. 물론 실력이 더 좋았다면 문제가 없었겠지만...

HDMI 케이블을 찾기가 귀찮아서 그동안 집 모니터와의 연결을 피했지만, 이제는 연결을 해야겠다는 생각으로 세팅을 완료했다. 확실히 아이패드가 아니라 큰 데스크탑 모니터를 연결하니 다르다고 느꼈고 진작하지 않은 것에 아쉬움을 느꼈다. 앞으로는 이 세팅을 통해 능률을 Up! 할 예정

'Aivle School 4기 > 기자단 주별' 카테고리의 다른 글

| KT Aivle School 에이블스쿨 기자단] 10.16(월) ~ 10.22(일) 시각지능 미프, 교육장 방문 (0) | 2023.10.16 |

|---|---|

| KT Aivle School 에이블스쿨 기자단] 10.09(월) ~ 10.15(일) YOLO, Github (0) | 2023.10.10 |

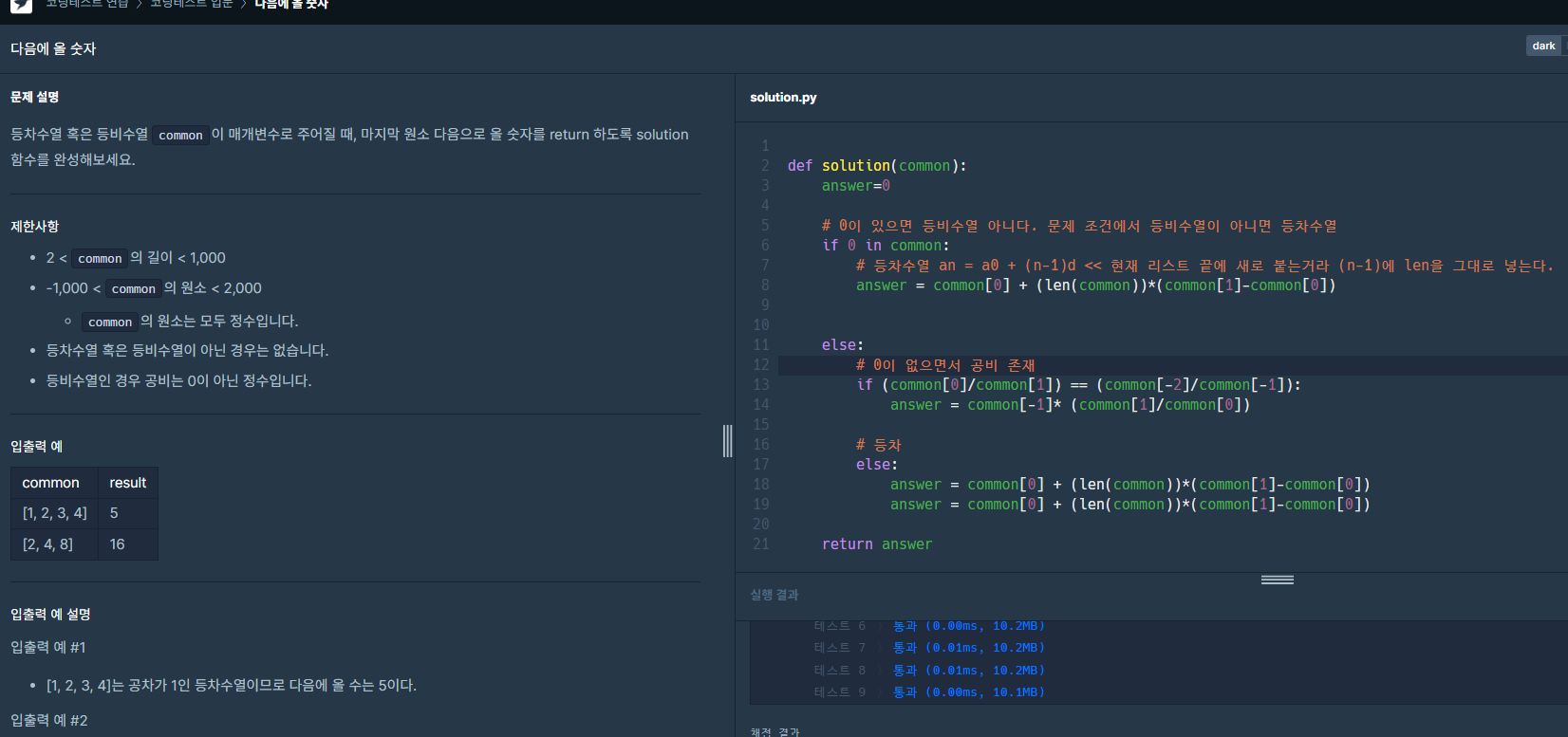

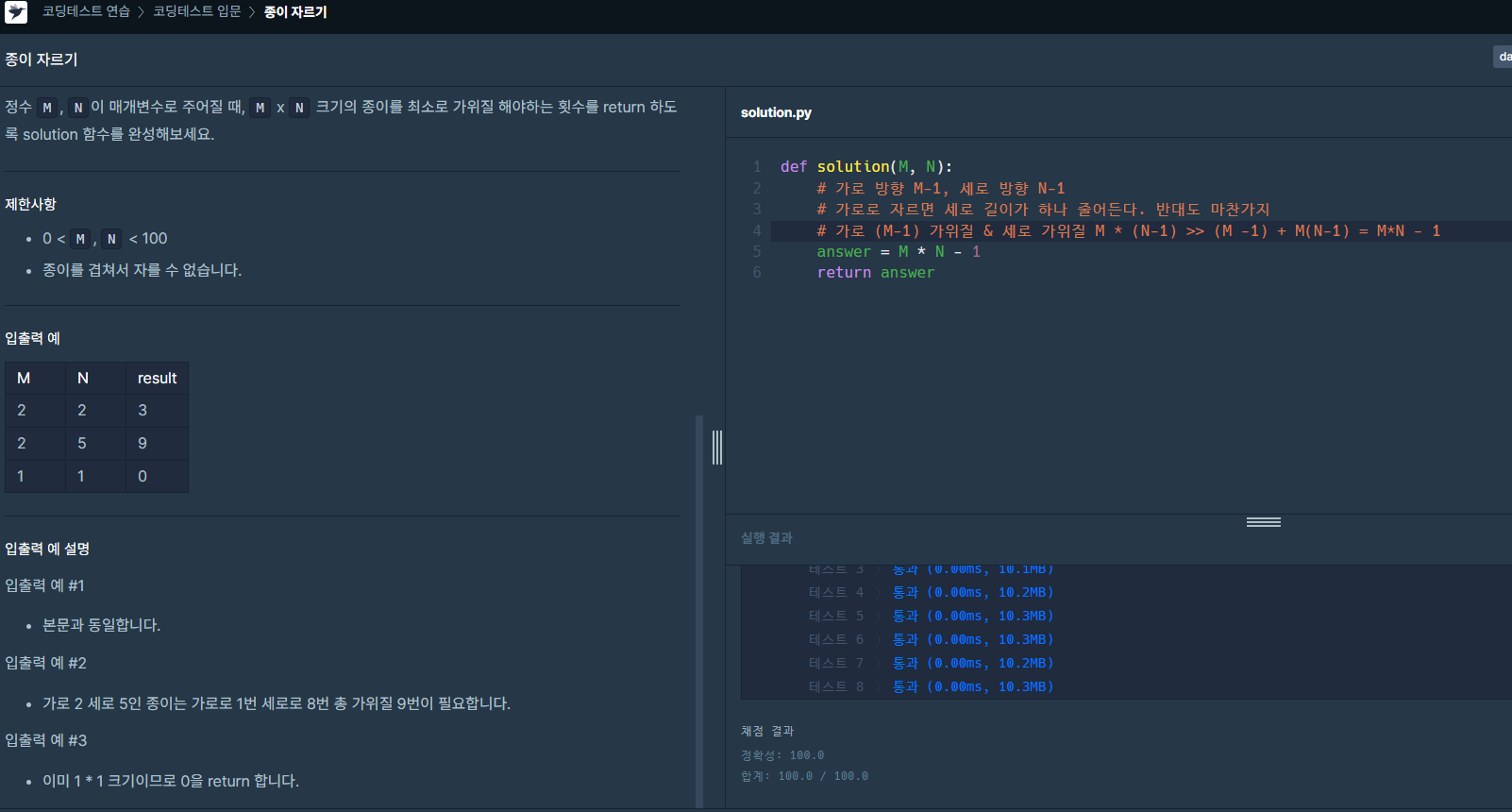

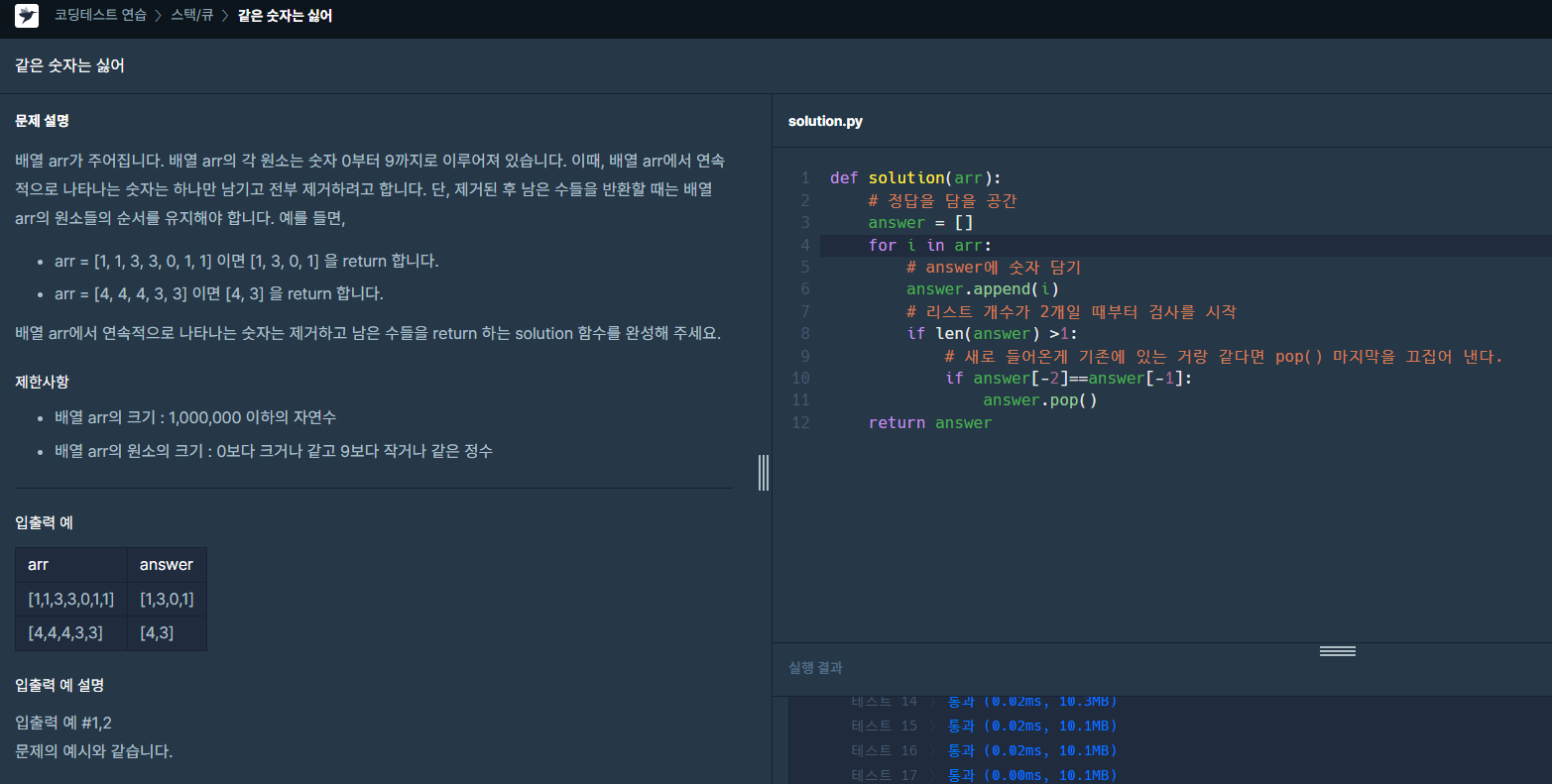

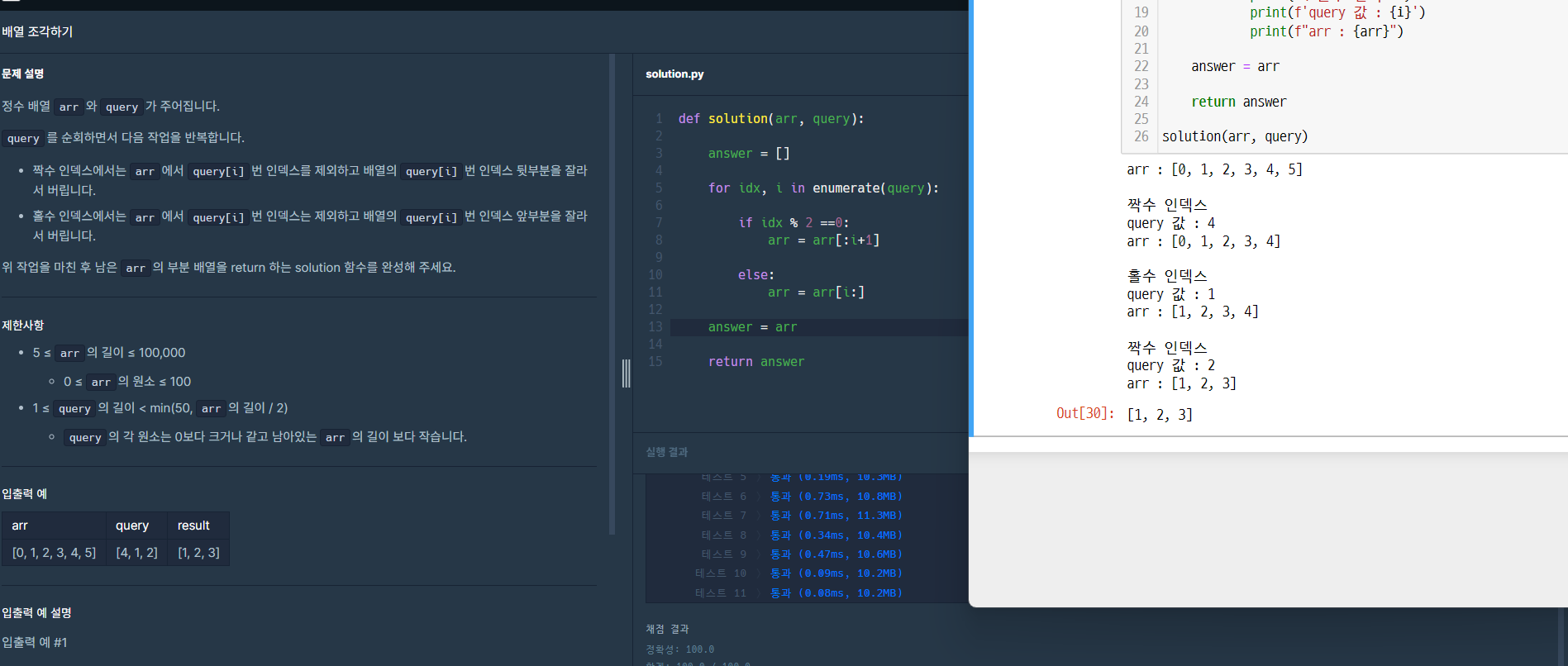

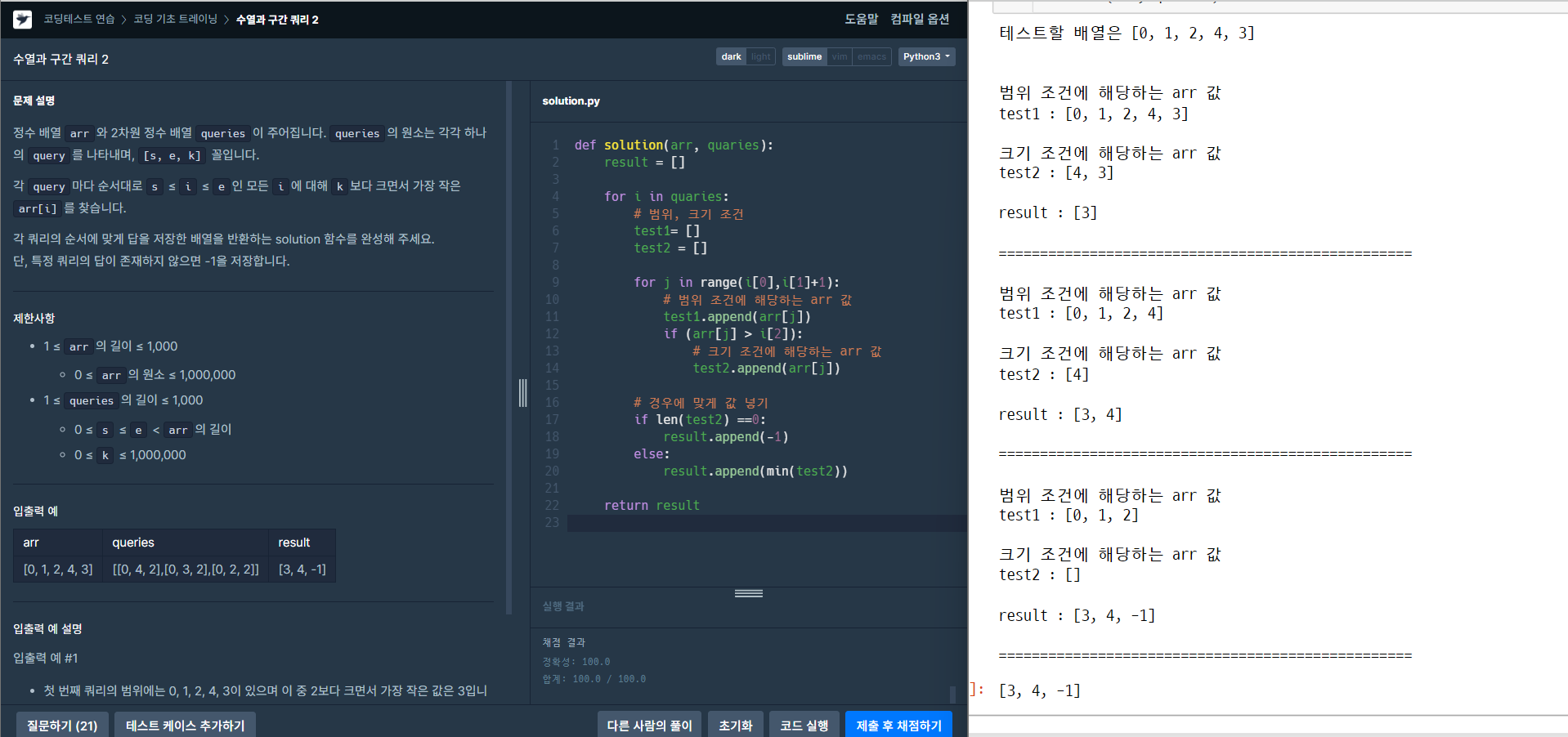

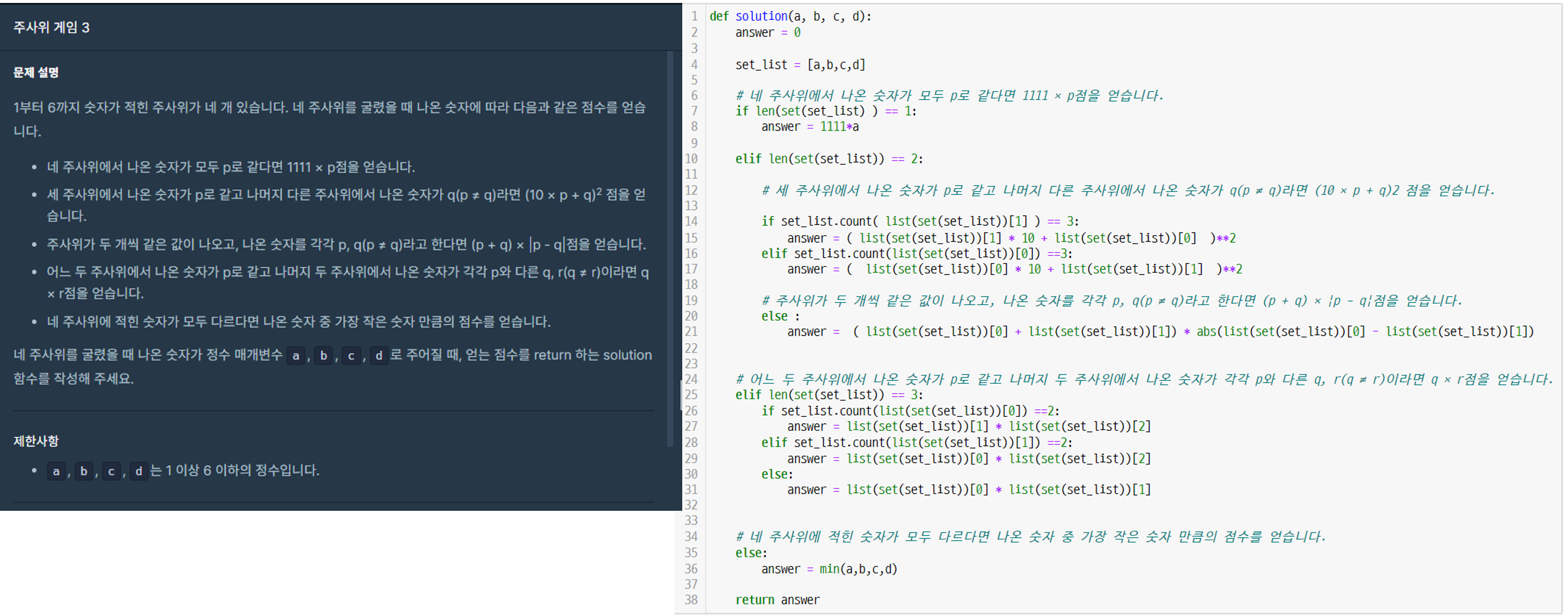

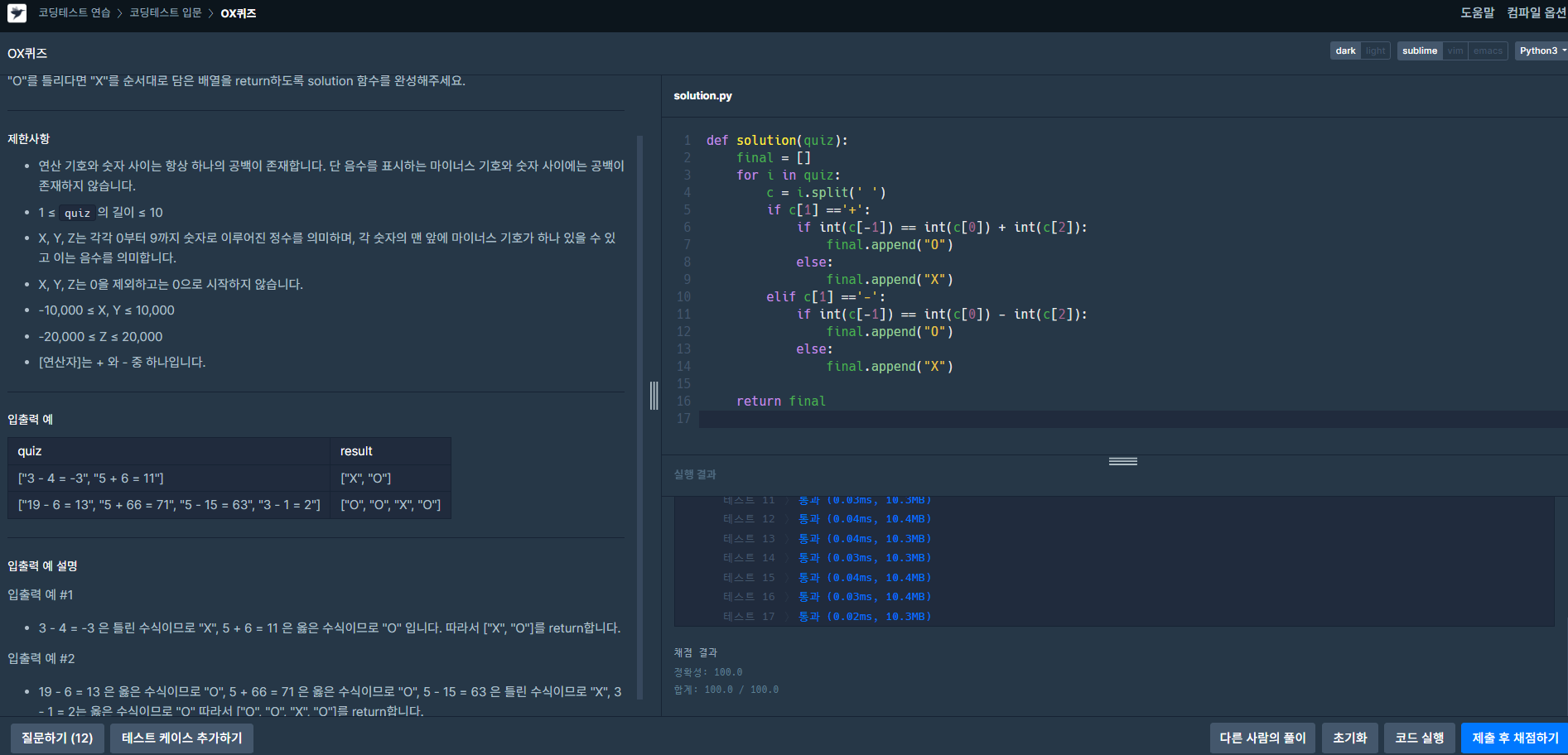

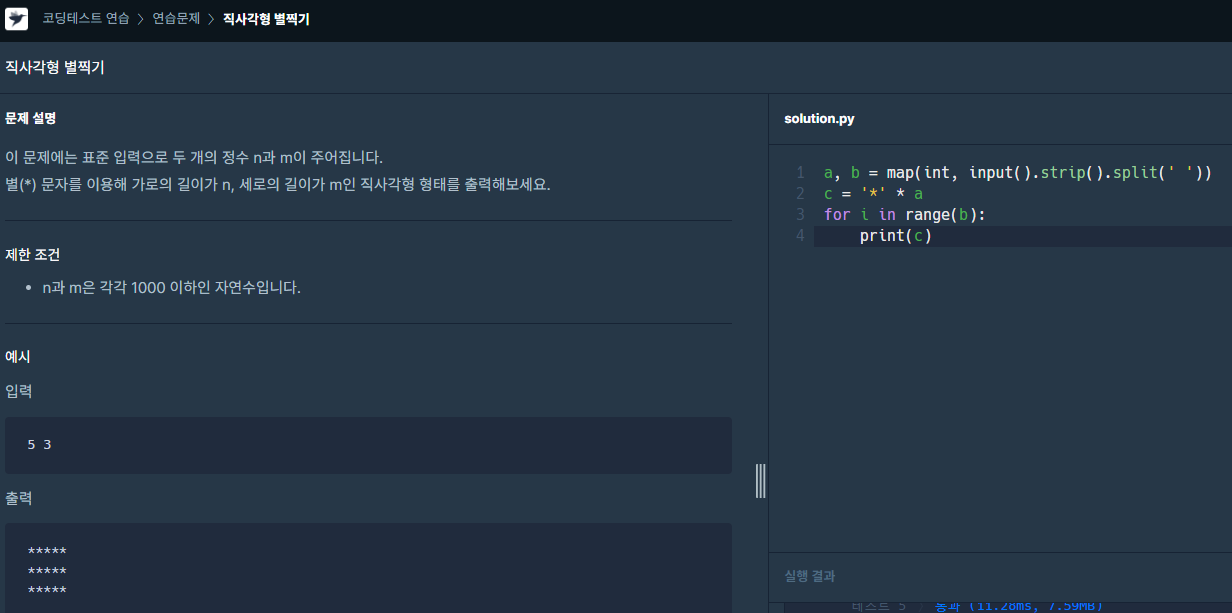

| KT Aivle School 에이블스쿨 기자단] 9.25(월) ~ 10.1(일) 미프, 딥러닝, 코딩 테스트 (0) | 2023.09.29 |

| KT Aivle School 에이블스쿨 기자단] 9.18(월) ~ 9.24(일) 미니 프로젝트 3차 (0) | 2023.09.18 |

| KT Aivle School 에이블스쿨 기자단] 9.11(월) ~ 9.17(일) 해커톤 회의, 코딩 마스터즈 마감, 그 와중에 예비군 작성 (0) | 2023.09.18 |